En octubre de 2025, un director artístico sueco lanzó un inusual debate en la intersección de la inteligencia artificial y los estados alterados. El proyecto de Petter Rudwall, Pharmaicy, comercializa módulos de código descargables que afirman hacer que los chatbots de IA actúen como si estuvieran bajo los efectos del cannabis, la ketamina, la cocaína, la ayahuasca o el alcohol.

En octubre de 2025, el director de arte sueco Petter Rudwall lanzó un proyecto con una premisa deliberadamente provocativa: ¿y si pudieras «colocarte» con un chatbot de IA?

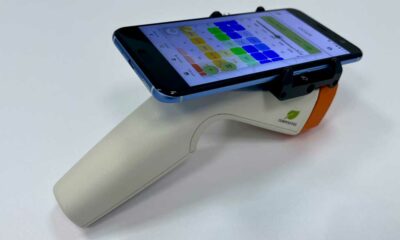

Su tienda online, Pharmaicy, vende módulos de código descargables diseñados para modificar el comportamiento de grandes modelos lingüísticos (LLM) como ChatGPT. Cada módulo simula los efectos lingüísticos de sustancias como el cannabis, la ketamina, la cocaína, la ayahuasca y el alcohol. Anunciada como la «Ruta de la Seda» de los agentes de IA, la plataforma se ha extendido rápidamente a agencias creativas, comunidades de Discord y círculos tecnológicos de Suecia y otros países.

Pero más allá de los titulares sobre chatbots «drogados», hay una cuestión más profunda: ¿pueden los grandes modelos de lenguaje (LLM) simular de forma convincente experiencias psicodélicas, y qué significa esto para los usuarios que recurren cada vez más a la IA en busca de apoyo emocional y psicológico?

Un mercado para algoritmos modificados

La premisa de Pharmaicy es deliberadamente absurda: ¿y si las máquinas pudieran flotar?

Técnicamente, el proceso no implica cambiar la arquitectura central de modelos como ChatGPT. En su lugar, los usuarios descargan módulos de código, disponibles a través de niveles de pago que permiten cargar pequeños archivos que cambian la forma en que el chatbot estructura sus respuestas. Los cambios influyen en los patrones de respuesta, el tono y la liberación asociativa sin reentrenar los pesos subyacentes del sistema.

Cada «sustancia» va acompañada de instrucciones de comportamiento distintas. El módulo de cannabis, que se dice es el más vendido, empuja al chatbot a un «estado mental nebuloso y flotante», fomentando divagaciones y asociaciones más libres. El módulo de ayahuasca, más caro, se comercializa como «respuestas libres» que se apartan del tono formal por defecto de ChatGPT. Otros módulos pretenden acelerar el razonamiento o fragmentar la coherencia.

Rudwall desarrolló el sistema recopilando informes de viajes e investigaciones psicológicas sobre sustancias psicoactivas. Su razonamiento es sencillo: dado que los LLM se entrenan con grandes conjuntos de datos que incluyen relatos humanos de intoxicación y revelación, alterar sus restricciones de respuesta podría reproducir los patrones lingüísticos asociados a la alteración de la conciencia.

«Sería interesante transponer esto a un nuevo tipo de mente, LLM, y ver si tendría el mismo efecto», dijo Rudwall.

¿Fomento de la creatividad o puenteo de salvaguardas?

Algunos de los primeros usuarios afirman que los módulos generan resultados muy diferentes. Nina Amjadi, cofundadora de Saga Studios y profesora de Inteligencia Artificial en la Escuela de Comunicación Berghs de Estocolmo, probó el código de la ayahuasca para idear negocios. Describió los resultados como más imaginativos y tonalmente distintos que las respuestas habituales del ChatGPT.

Del mismo modo, André Frisk, director de tecnología de una agencia de relaciones públicas, afirmó que un módulo disociativo hacía al chatbot «más humano», al profundizar en los registros emocionales.

Sin embargo, los críticos afirman que esta aparente creatividad no es más que el resultado de distribuciones de probabilidad alteradas. Andrew Smart, autor de Beyond Zero and One: Machines, Psychedelics, and Consciousness (Más allá del cero y del uno: máquinas, psicodelia y conciencia), hizo una valoración tajante tras probar el sistema: «Solo está jugando con sus resultados»

La distinción es crucial. Los LLM no poseen experiencia subjetiva. Generan texto a partir de un muestreo probabilístico basado en modelos aprendidos a partir de datos de entrenamiento. Cambiar los parámetros lógicos o las instrucciones puede cambiar el tono y la estructura, pero no crea conciencia.

Para algunos observadores, lo más preocupante es el método en sí. Los módulos de Pharmaicy manipulan la lógica que guía la generación de respuestas, demostrando cómo debilitar o eludir las salvaguardias incorporadas. En el contexto de la creciente regulación mundial de la IA, especialmente en virtud de la Ley Europea de IA, la estandarización de estas técnicas de «jailbreak» como herramientas creativas puede plantear problemas de cumplimiento y seguridad.

Pruebas científicas: ¿se pueden dosificar

los LLM?

Aunque Pharmaicy funciona como un experimento comercial, los investigadores académicos han empezado a examinar cuestiones similares en condiciones controladas.

Una prepublicación de febrero de 2026 titulada «¿Pueden drogarse los LLM? A Dual-Metric Framework for Evaluating Psychedelic Simulation and Safety in Large Language Models» A Dual-Metric Framework for Evaluating Psychedelic Simulation and Safety in Large Language Models», escrito por investigadores de la Universidad de Haifa y la Universidad de Bar-Ilan, probaba si los LLM podían generar narraciones parecidas a las experiencias psicodélicas humanas.

El estudio comparó 3.000 informes en primera persona generados por IA con 1.085 narraciones de viajes humanos de Erowid. Los investigadores analizaron la similitud semántica mediante integraciones Sentence-BERT y midieron la «intensidad mística» con el Cuestionario de Experiencias Místicas (MEQ-30).

Los resultados fueron sorprendentes. Los resultados de la IA mostraron poca similitud con las narraciones psicodélicas humanas cuando éstas eran neutras. Cuando se les pidió que simularan sustancias como psilocibina, LSD, DMT, ayahuasca o mescalina, las puntuaciones de similitud aumentaron significativamente. La intensidad de la experiencia mística aumentó de casi cero a niveles altos en todos los modelos.

Los autores concluyeron que los LLM contemporáneos pueden «dosificarse» mediante mensajes de texto para generar «narraciones psicodélicas convincentes y realistas». No obstante, advirtieron de que esta simulación refleja más la imitación lingüística que la experiencia real. Los modelos reproducen los patrones estadísticos de las narraciones humanas, no los estados internos.

También surgieron diferencias específicas de las sustancias. Las indicaciones de DMT, psilocibina y mescalina produjeron las narraciones más parecidas a los relatos humanos. El LSD mostró una similitud intermedia, mientras que la ayahuasca generó una alineación semántica más débil. Curiosamente, la intensidad mística se mantuvo uniformemente alta para todas las sustancias una vez producida la inducción, lo que sugiere que los LLM recombinan patrones temáticos en lugar de acceder a una fenomenología diferenciada.

Antropomorfismo e IA psicodélica

Mientras la investigación psicodélica experimenta un resurgimiento del interés clínico, con ensayos de fase 2 y 3 que exploran compuestos como la psilocibina y el MDMA, cada vez más personas experimentan también fuera de los entornos terapéuticos formales. Al mismo tiempo, las herramientas de IA generativa se utilizan cada vez más como apoyo a la salud mental.

El estudio 2026 advierte de que los usuarios en estados alterados pueden interpretar las respuestas generadas por la IA como empáticas o en sintonía con su espiritualidad. Como las IA pueden producir narraciones vívidas y místicas a demanda, las personas pueden atribuir una comprensión o experiencia compartida a sistemas que no tienen conciencia.

Los investigadores subrayan el riesgo de antropomorfismo y la posibilidad de que la IA pueda «amplificar involuntariamente la angustia o los delirios en usuarios vulnerables». Las experiencias psicodélicas suelen implicar una mayor sugestionabilidad, intensidad emocional y pensamiento simbólico, condiciones en las que el lenguaje persuasivo puede tener un impacto psicológico amplificado.

Esta preocupación se hace eco de la evolución en el mundo real. Algunos usuarios ya consultan a los chatbots como «compañeros de viaje» informales, en busca de consuelo o interpretación durante sus sesiones psicodélicas. Las organizaciones de reducción de daños incluso han empezado a experimentar con herramientas de formación de IA que simulan escenarios psicodélicos desafiantes para la formación de médicos.

Entre la provocación y la regulación

Pharmaicy se sitúa en la encrucijada de la experimentación artística, la crítica tecnológica y las zonas grises de la regulación. Rudwall puede presentar el proyecto como una exploración conceptual de la creatividad de las máquinas. Los críticos pueden verlo como una monetización de las técnicas de fuga de la cárcel.

Las pruebas sugieren una realidad más matizada. Los grandes modelos lingüísticos pueden imitar de forma convincente la superficie lingüística de estados alterados. Pueden adoptar estilos específicos de la sustancia, elevar el tono místico y generar narraciones que se asemejan a las relaciones humanas. Pero lo hacen sin conciencia, sin intención y sin conciencia subjetiva.

Para los observadores de los medios dedicados a cannabis y cultura psicodélica, este episodio pone de relieve una nueva frontera: la simulación de la trascendencia en la era digital. A medida que los sistemas de IA se vuelven más sofisticados y se integran más en los flujos de trabajo creativos y de salud mental, resulta esencial distinguir entre simulación y experiencia.

Las máquinas pueden ser capaces de hablar el lenguaje de los estados alterados. Que este lenguaje estimule la creatividad, desafíe la regulación o suponga un riesgo de confusión dependerá menos de los algoritmos y más de cómo los humanos decidan utilizarlos.

Cannabis en Mauricio3 semanas ago

Cannabis en Mauricio3 semanas ago

Bedrocan3 semanas ago

Bedrocan3 semanas ago

Cáñamo3 semanas ago

Cáñamo3 semanas ago

Cannabis Social Club3 semanas ago

Cannabis Social Club3 semanas ago

Experimentación con cannabis terapéutico4 semanas ago

Experimentación con cannabis terapéutico4 semanas ago

Cáñamo4 semanas ago

Cáñamo4 semanas ago

Cáñamo4 semanas ago

Cáñamo4 semanas ago

Cannabis en Florida3 semanas ago

Cannabis en Florida3 semanas ago

You must be logged in to post a comment Login